Ở bài viết trước đây Prompt Engineering – Nghệ thuật giao tiếp với AI, Lemon’s tribe đã từng nhắc đến 1 số kỹ thuật để viết prompt ra lệnh cho AI. Vài năm về trước, việc viết prompt đòi hỏi nhiều về mặt kỹ thuật, thì đến năm 2025, với mức độ phát triển mạnh mẽ của các model AI, việc viết prompt đã trở nên dễ dàng hơn rất nhiều. Tuy viết prompt bây giờ có thể ví von vui như viết văn, nhưng vẫn đòi hỏi người viết nắm một số kỹ thuật nhất định để tránh được những sai lầm không đáng có của AI. Để có câu trả lời chính xác, sáng tạo và đúng trọng tâm, người dùng giờ đây áp dụng đủ chiêu thức: nào là bắt AI phải suy nghĩ từng bước, chia nhỏ vấn đề, tự kiểm tra độ chính xác, đóng vai nhiều chuyên gia tranh luận với nhau… Nghe có vẻ như “huấn luyện” một học sinh giỏi, phải không? Bài viết này sẽ giúp bạn cập nhật những kỹ thuật prompt mới nhất – theo phong cách gần gũi, dễ hiểu – để bạn khai thác tối đa sức mạnh AI mà không cần là coder.

Từ những lời nhắc cơ bản đến cả một “hộp công cụ” prompt

Thời kỳ đầu, prompt engineering chỉ xoay quanh vài chiến thuật cơ bản: ví dụ như đưa ví dụ mẫu (few-shot prompting) hay đơn giản là đặt câu lệnh rõ ràng (zero-shot prompting). Nhưng rồi người ta nhận ra rằng cách đặt yêu cầu có thể thay đổi hoàn toàn chất lượng câu trả lời từ AI. Dần dần, các nhà nghiên cứu và chuyên gia đã sáng tạo ra hàng loạt kỹ thuật mới để khai thác mô hình ngôn ngữ hiệu quả hơn.

Một bước ngoặt lớn là kỹ thuật Chuỗi suy nghĩ (Chain-of-Thought, CoT). Ý tưởng rất đơn giản: thay vì yêu cầu câu trả lời ngay, ta nhắc AI “hãy suy nghĩ từng bước một”. Điều này giống như khi con người giải toán, ta viết ra từng phép tính trung gian. CoT đã giúp các mô hình AI giải quyết bài toán phức tạp tốt hơn hẳn. Ví dụ, các mô hình như OpenAI’s GPT-o1 hay DeepSeek-R1 đã dùng phương pháp CoT để đạt thành tích chưa từng có về độ chính xác trên các bài kiểm tra khó. Tuy nhiên, CoT cũng bộc lộ nhược điểm: vì phải liệt kê rất nhiều bước logic, câu trả lời trở nên dài dòng, tốn thời gian và tài nguyên. Các mô hình reasoning (suy luận) kiểu CoT có xu hướng tạo ra đáp án rất dài và chi tiết, dẫn đến độ trễ cao (phản hồi chậm) và đòi hỏi tính toán nhiều hơn.1

Vấn đề “dài dòng” này đôi khi được gọi vui là model bloat – sự “phình to” không cần thiết của mô hình. Hiểu đơn giản: AI nghĩ kỹ thì tốt đấy, nhưng nghĩ quá lâu và nói quá nhiều lại thành ra chậm chạp. Vì thế, các nhà nghiên cứu đã bắt đầu sáng tạo ra một thế hệ kỹ thuật prompt mới nhằm giữ lại lợi ích của CoT (tư duy mạch lạc) nhưng tăng tốc độ và giảm chi phí. Chúng ta hãy cùng lần lượt khám phá những kỹ thuật mới này, từ “Nguyên tử suy nghĩ” (Atom-of-Thought) cho đến “Bản thảo suy nghĩ” (Chain-of-Draft) và nhiều ý tưởng thú vị khác. Mỗi kỹ thuật đều như một công cụ mới trong “hộp đồ nghề” của người dùng AI, giúp ta ứng phó với những nhiệm vụ khác nhau một cách tối ưu.

Chuỗi suy nghĩ (CoT) – Khi AI biết suy nghĩ từng bước

Trước khi đi vào các kỹ thuật mới, hãy hiểu rõ hơn về Chuỗi suy nghĩ (Chain-of-Thought, CoT) – nền tảng mà nhiều phương pháp nâng cao xây dựng trên đó. CoT yêu cầu AI đưa ra các bước lập luận trung gian trước khi chốt đáp án cuối. Nhờ “nghĩ thành tiếng” như vậy, AI có thể giải những bài toán phức tạp, câu hỏi đố mẹo hay suy luận logic tốt hơn nhiều so với việc trả lời một phát ngay. Có thể coi CoT như việc bạn yêu cầu AI “Hãy giải thích cách anh/chị đi đến câu trả lời”.2

Lợi ích: CoT giúp câu trả lời có cấu trúc rõ ràng và logic hơn, giảm lỗi sai trong các nhiệm vụ phức tạp. Tuy nhiên, như đã đề cập, nhược điểm là CoT tạo ra câu trả lời rất dài. Mô hình liệt kê càng nhiều bước thì số token nó tạo ra càng nhiều, đồng nghĩa với chi phí tính toán cao và trả lời chậm hơn.

Một cách hình tượng: Có người ví CoT giống như làm theo công thức nấu ăn từng bước một – rất phù hợp cho những vấn đề tuyến tính, nhưng nếu bài toán quá phức tạp thì cách làm tuần tự này trở nên kém hiệu quả. Vậy làm sao để AI suy nghĩ hiệu quả hơn? Các kỹ thuật mới ra đời chính là để trả lời câu hỏi đó.

Nguyên tử suy nghĩ (AoT) – Chia để trị, suy nghĩ song song

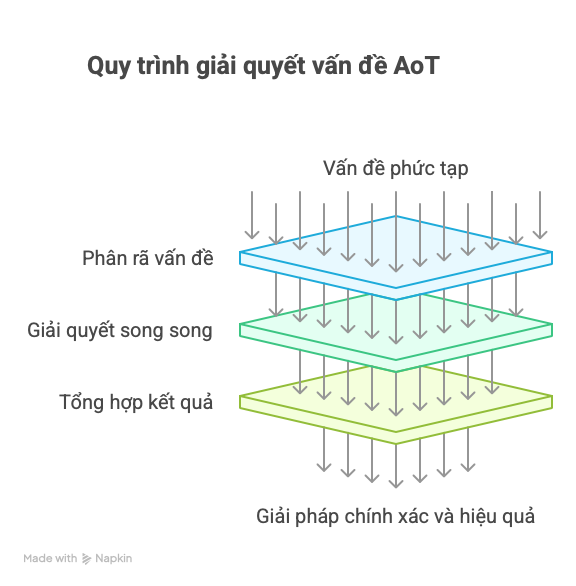

Atom-of-Thought (AoT) là một kỹ thuật prompt mới xuất hiện nhằm khắc phục nhược điểm của CoT. Nếu CoT là suy nghĩ tuần tự, bước này nối bước kia, thì AoT cho phép AI “chia nhỏ” vấn đề thành các phần độc lập (các nguyên tử) và giải quyết đồng thời. Nói cách khác, AoT áp dụng chiến lược “chia để trị”: phân tách câu hỏi phức tạp thành những câu hỏi con đơn giản hơn (gọi là các “atomic question”), giải từng cái một, rồi hợp nhất kết quả để có đáp án cuối cùng.3

Hãy tưởng tượng bạn lên kế hoạch du lịch: thay vì làm tuần tự từng việc (đặt vé máy bay xong mới tìm khách sạn, rồi mới lên lịch trình tham quan) như cách CoT, bạn có thể chia ra nhiều nhiệm vụ độc lập – đặt vé, đặt phòng, tìm địa điểm vui chơi – làm song song rồi tổng hợp lại. Nguyên tử suy nghĩ hoạt động đúng theo kiểu đó. Một so sánh thú vị khác: CoT giống như nấu ăn theo công thức, còn AoT giống chuẩn bị nguyên liệu riêng lẻ rồi mới nấu thành món Nhờ làm các phần việc nhỏ song song, tổng thời gian được rút ngắn đáng kể.4

Theo một nghiên cứu từ Hong Kong và Trung Quốc, khi tích hợp kỹ thuật AoT vào phiên bản GPT-4 nhỏ (GPT-4o mini), mô hình này đã vượt qua cả những mô hình suy luận hàng đầu như o3-mini hay DeepSeek-R1 trên nhiều bộ kiểm tra, ví dụ hơn mô hình o3-mini 3,4% và hơn DeepSeek-R1 đến 10,6% trên bộ dữ liệu HotpotQA. Nói đơn giản, AoT vừa nhanh hơn vừa có thể cho đáp án chính xác hơn trong một số trường hợp nhờ cách tiếp cận song song. Một chuyên gia còn ví von rằng Chuỗi suy nghĩ như cái búa thường, còn Nguyên tử suy nghĩ là cái búa chuyên dụng – bạn có thể dùng búa thường cho mọi việc, nhưng nếu có một chiếc búa thiết kế riêng (đóng đinh trên tường thạch cao chẳng hạn) và biết cách dùng, công việc sẽ nhanh gọn hơn nhiều.5

Tất nhiên, AoT không phải hoàn hảo cho mọi bài toán. Điểm mấu chốt là phải tìm được cách chia vấn đề hợp lý thành các phần độc lập. Nếu phân rã sai (ví dụ tách các phần có quan hệ phụ thuộc chặt chẽ), AI có thể ghép câu trả lời sai lệch. Dù vậy, AoT đang mở ra hướng mới để tăng tốc độ tư duy của AI – đặc biệt hữu ích cho doanh nghiệp muốn dùng mô hình nhỏ hơn, chi phí rẻ hơn mà vẫn đạt độ chính xác cao.6

Chuỗi bản thảo (CoD) – Nghĩ nhanh bằng cách viết ít lại7

Một cách tiếp cận khác để tăng tốc AI là Chain-of-Draft (CoD) – tạm dịch: Chuỗi bản thảo hoặc bản nháp suy nghĩ. Kỹ thuật này ra đời từ một quan sát: con người khi suy nghĩ thường dùng ghi chú ngắn gọn, viết các ý chính chứ không viết tràng giang từng câu hoàn chỉnh. Vậy tại sao không yêu cầu AI cũng làm như vậy? CoD chính là yêu cầu AI suy nghĩ từng bước nhưng chỉ ghi lại mỗi bước bằng vài từ ngắn gọn, thay vì cả câu dài.

CoD nhằm giải quyết điểm nghẽn của CoT: khi mô hình suy luận tạo ra quá nhiều câu chữ, nó vừa chậm vừa có thể lan man. Trong một bài báo của nhóm nghiên cứu tại Zoom, tác giả lưu ý rằng con người có xu hướng dùng ký hiệu hoặc dàn ý ngắn để nắm ý chính thay vì dài dòng – và họ áp dụng ý tưởng đó cho AI. Cụ thể, thay vì prompt tiêu chuẩn kiểu CoT: “Hãy nghĩ từng bước để trả lời câu hỏi sau. Cuối cùng đưa ra đáp án sau ký hiệu ####”, thì prompt kiểu CoD được chỉnh thành: “Hãy nghĩ từng bước, nhưng chỉ giữ lại bản nháp tối thiểu cho mỗi bước (tối đa 5 từ). Cuối cùng trả lời sau ký hiệu ####“.

Kết quả thật ấn tượng: Khi so sánh trên nhiều bài toán, nhóm nghiên cứu thấy CoD cho độ chính xác tương đương hoặc cao hơn CoT nhưng số từ sử dụng giảm đến 92,4%. Nói cách khác, mô hình tiết kiệm được gần 93% lượng từ, đồng nghĩa với tiết kiệm chi phí và tăng tốc độ xử lý đáng kể, mà chất lượng đáp án không hề giảm sút. Với các ứng dụng AI thời gian thực cần phản hồi nhanh, lợi ích giảm độ trễ này cực kỳ quan trọng.

CoD có thể xem như phiên bản “viết tốc ký” của CoT. Thay vì viết cả đoạn văn cho mỗi bước lập luận, AI chỉ ghi lại ý chính bằng vài từ, giống như cách chúng ta ghi chú vào sổ tay. Kỹ thuật này đòi hỏi người dùng phải thiết kế prompt khá cụ thể (như ví dụ trên, giới hạn số từ mỗi bước), nhưng bù lại nó giúp AI tập trung vào cốt lõi vấn đề thay vì sa đà giải thích.

Tất nhiên, viết ngắn quá cũng có mặt trái: mô hình có thể bỏ sót chi tiết hoặc khó diễn đạt chính xác suy nghĩ phức tạp chỉ trong 5 từ. Do đó CoD phù hợp nhất cho những bài toán mà sự ngắn gọn được ưu tiên, và mô hình vẫn phải đủ thông minh để không viết tắt tới mức khó hiểu. Dù vậy, thành công của CoD cho thấy một điều: đôi khi “ít hơn lại tốt hơn” – hướng dẫn AI tiết chế lời văn có thể khiến nó trả lời nhanh và vẫn đúng trọng tâm.

Skeleton-of-Thought (SoT) – Dàn ý trước, điền nội dung sau8

Sau khi có AoT và CoD, một câu hỏi đặt ra: liệu ta có kết hợp được ưu điểm của cả hai? Câu trả lời là Skeleton-of-Thought (SoT) – tạm dịch: Khung xương suy nghĩ. Đúng như tên gọi, SoT hướng dẫn AI tạo một bộ khung (sườn ý chính) cho câu trả lời trước, rồi sau đó điền chi tiết cho từng ý, và có thể điền song song. Kỹ thuật này lấy cảm hứng từ chính cách con người viết và suy nghĩ: đầu tiên lập dàn ý, sau đó mới viết hoàn chỉnh.

Cách hoạt động của SoT: đầu tiên AI sẽ phác thảo các điểm chính của câu trả lời – đó là “skeleton”. Sau khi có skeleton, AI tiến hành triển khai đồng thời các ý: mỗi ý chính được phát triển thành vài câu chi tiết (giai đoạn này giống AoT, vì có thể làm song song các phần độc lập). Cuối cùng, các phần được tổng hợp lại thành bài hoàn chỉnh.

Nhờ phương pháp này, SoT đạt được hai lợi ích: tiết kiệm thời gian (do phần “điền nội dung” có thể chạy song song tương tự AoT) và cải thiện tính logic mạch lạc (do đã có sườn trước nên tránh lạc đề hoặc trùng lặp). Nhóm tác giả từ Đại học Thanh Hoa (Trung Quốc) và Microsoft Research đã thử nghiệm SoT trên nhiều mô hình và nhận thấy thời gian phản hồi nhanh gần gấp đôi so với CoT trong một số trường hợp, đồng thời độ chính xác cũng tăng lên đáng kể. Ví dụ, khi hỏi Claude AI một câu hỏi mở về chiến lược giải quyết mâu thuẫn nơi công sở, dùng SoT giúp giảm thời gian trả lời từ 22 giây xuống còn 12 giây (nhanh hơn ~1,83 lần), còn với mô hình Vicuna 33B thì nhanh hơn tới 2,69 lần.

SoT được đánh giá là một kỹ thuật đầy hứa hẹn, kết hợp được khả năng tư duy có tổ chức (như viết dàn ý) với hiệu suất cao (như AoT/CoD). Dĩ nhiên, SoT cũng không phải luôn luôn tốt hơn – nếu câu hỏi quá đơn giản thì việc lập dàn ý có khi lại tốn công không cần thiết. Nhưng trong những bài toán mở, yêu cầu câu trả lời có cấu trúc rõ ràng (ví dụ viết bài luận, lên kế hoạch, trả lời theo bullet points), SoT tỏ ra cực kỳ hữu dụng.

Logic-of-Thought (LoT) – Tiêm logic hình thức vào trí não AI

Không phải mọi câu hỏi đều giống nhau. Có những vấn đề đòi hỏi tư duy logic chặt chẽ, thậm chí cần lập luận kiểu toán học hoặc luận lý. Với dạng này, một kỹ thuật prompt mới đã ra đời mang tên Logic-of-Thought (LoT) – tạm hiểu: luồng suy nghĩ có logic hình thức. Thay vì chỉ bảo AI “nghĩ từng bước” chung chung, LoT hướng dẫn AI suy luận bằng cách sử dụng ngôn ngữ logic mệnh đề, kiểm tra tính đúng/sai của các mệnh đề, rồi từ đó suy ra đáp án.9

Cụ thể, LoT thường gồm ba bước: (1) Trích xuất logic – AI sẽ diễn giải vấn đề thành các mệnh đề logic hoặc tiền đề dạng “Nếu… thì…”; (2) Suy luận bằng logic – AI thao tác trên các mệnh đề đó (ví dụ áp dụng luật logic, kiểm tra tính nhất quán) để tìm ra kết luận; (3) Giải thích bằng ngôn ngữ tự nhiên – AI chuyển kết luận logic thành câu trả lời bình thường cho người dùng10. Quá trình này buộc mô hình phải “suy nghĩ như một nhà logic học” thay vì trả lời cảm tính.

Một ví dụ điển hình: câu hỏi kiểm tra logic kiểu LSAT. Với LoT, AI sẽ tách từng điều kiện trong đề thành ký hiệu logic, dùng phép suy luận để tìm đáp án, rồi giải thích lại bằng lời. Kết quả cho thấy LoT cải thiện độ chính xác rõ rệtcho các bài toán suy luận logic, so với việc chỉ dùng CoT thường. Nghiên cứu báo cáo rằng LoT đã được thử nghiệm trên 5 dạng bài logic và giúp nâng cao hiệu suất của nhiều phương pháp prompt khác (Zero-shot, CoT, v.v.) trong việc tìm câu trả lời đúng. Nên nhớ, LoT không làm cho AI thông minh hơn một cách thần kỳ – nó chỉ là một “mánh” chuyên dụng cho loại câu hỏi đòi hỏi tư duy logic. Như tác giả Lance Eliot nhấn mạnh, LoT là “một công cụ giá trị cho những ai cần suy luận logic, nhưng không phải đạn bạc cho mọi vấn đề”. Điều thú vị là LoT cho thấy chúng ta có thể kết hợp kiến thức về logic vào prompt, biến prompt thành dạng “bài toán logic” để AI giải. Đây có thể là hướng đi cho những ứng dụng yêu cầu độ chính xác cao, chẳng hạn kiểm chứng luận điểm, làm toán chứng minh, v.v.11

Tree-of-Thought (ToT) – Khi AI biết “đẽo cành” tìm đáp án

Cho đến giờ, chúng ta đã nói nhiều về “chuỗi” suy nghĩ tuyến tính và các biến thể. Nhưng bộ não con người đôi khi hoạt động không theo một đường thẳng – ta có thể nghĩ ra nhiều phương án khác nhau, rồi loại bỏ dần những hướng đi sai. Đó chính là ý tưởng của Tree-of-Thought (ToT) – cây suy nghĩ. Kỹ thuật này tổ chức quá trình suy luận của AI dưới dạng một cái cây phân nhánh thay vì một đường thẳng duy nhất12.

Cụ thể, với ToT, AI được hướng dẫn: “Hãy thử nhiều bước giải khác nhau, nếu bế tắc thì quay lui (backtrack) và thử nhánh khác”. Mỗi node trên cây là một trạng thái hay một phần lời giải. AI có thể tạo ra các “nhánh” – tức các khả năng tiếp diễn – từ mỗi trạng thái hiện tại, giống như ta lựa chọn nước cờ trong cờ vua. Sau đó, AI sẽ đánh giá các nhánh: nhánh nào có vẻ dẫn tới đích, nhánh nào cụt thì bỏ13. Cuối cùng, nó chọn con đường tốt nhất trên cây làm đáp án.

Thử tưởng tượng bạn hỏi AI một câu đố logic: “Nếu A > B, B > C, vậy ai thấp nhất?”. Theo CoT thường, mô hình sẽ chọn một hướng giải và đi đến kết luận. Nhưng theo ToT, mô hình có thể thử nhiều giả thuyết: giả sử A cao nhất, hoặc B cao nhất, v.v., tạo thành nhiều nhánh suy nghĩ. Rồi nó kiểm từng giả thuyết so với dữ kiện, loại bỏ những nhánh sai. Kết quả là AI có cơ hội sửa sai trong quá trình thay vì đi nhầm đường đến tận cuối. ToT đặc biệt hữu dụng cho những vấn đề cần thử nghiệm nhiều khả năng, ví dụ giải ô chữ, sudoku, lập kế hoạch có nhiều phương án lựa chọn.

Nghiên cứu cho thấy ToT kết hợp tốt với phương pháp tự nhất quán (self-consistency), tức là cho AI thử nhiều hướng rồi lấy kết quả số đông hoặc kết quả tốt nhất. Thực tế, ToT đã được thử trong các mô hình LLM và cho thấy khả năng cải thiện việc giải quyết bài toán khó bằng cách không bị giới hạn vào một hướng duy nhất14. Có thể xem ToT như bước tiến hóa của CoT: từ một chain thẳng thành một tree phân nhánh linh hoạt hơn.

Điểm cần lưu ý khi dùng ToT là phải có cách hướng dẫn AI tạo nhánh và đánh giá nhánh. Người dùng cần thiết kế prompt sao cho mô hình hiểu được khi nào nên tách ý thành nhánh mới, và làm sao để biết nhánh nào hứa hẹn. Đây là lĩnh vực còn đang nghiên cứu, nhưng những kết quả ban đầu rất hứa hẹn cho thấy AI có thể “tư duy” gần giống con người hơn khi biết khám phá nhiều hướng rồi chọn lọc lại.

Đa góc nhìn và nhập vai – Để AI tranh luận với chính mình

Bạn muốn có một câu trả lời toàn diện hơn? Hãy thử cho AI “đội nhiều mũ”! Một kỹ thuật prompt thú vị đang được sử dụng là yêu cầu AI đóng vai nhiều người khác nhau hoặc phân tích từ nhiều góc nhìn khác nhau trước khi trả lời. Kỹ thuật này có thể gọi là Multi-Perspective Prompting (nhắc đa góc nhìn) hoặc Mega-Personas Prompting.

Cách làm rất đơn giản: bạn đặt ra yêu cầu cho AI như “Hãy phân tích vấn đề X dưới vai trò của 3 chuyên gia: một nhà khoa học dữ liệu, một CEO, và một người dùng bình thường”. AI sẽ tạo ra nội dung với giọng điệu và luận điểm tương ứng với từng vai, sau đó có thể tổng hợp lại. Kết quả: câu trả lời trở nên đa chiều và sâu sắc hơn thay vì một chiều. Ví dụ, khi hỏi về việc ứng dụng AI trong bán hàng, nếu AI trả lời dưới góc nhìn của một chuyên viên phân tích dữ liệu, một giám đốc kinh doanh, và một khách hàng – chúng ta sẽ thu được các ý kiến rất phong phú và toàn diện. Thật vậy, một lời khuyên từ chuyên gia là hãy trộn nhiều personas để nội dung không bị thiên lệch: “viết về AI trong bán hàng nhưng dưới góc nhìn của một nhà phân tích, một lãnh đạo bán hàng và một khách hàng”. Điều này làm câu trả lời đầy đủ, nhiều màu sắc và dễ đồng cảm với người đọc hơn.15

Tương tự, ta cũng có thể yêu cầu AI tự tạo ra một cuộc tranh luận giả lập. Ví dụ: “Hãy đóng vai hai chuyên gia với quan điểm trái ngược nhau về chủ đề Y và tranh luận. Cuối cùng, tóm tắt kết luận chung.” Bằng cách này, AI sẽ tự “phản biện” chính nó, đưa ra cái nhìn cân bằng và làm rõ các khía cạnh của vấn đề.

Kỹ thuật đa góc nhìn rất hữu ích khi chúng ta muốn tránh thiên kiến hoặc muốn có thêm ý tưởng sáng tạo. AI đóng vai nhà phê bình sau khi đóng vai người đề xuất ý tưởng, hoặc AI tự hỏi lại chính mình từ quan điểm đối lập… đều là những cách để khai thác tối đa kiến thức của mô hình. Quan trọng là, những lời nhắc này giúp AI không bị mắc kẹt ở một lối suy nghĩ duy nhất, giống như việc brainstorm với một nhóm thay vì suy nghĩ một mình.

Step-Around Prompting – Tránh bẫy thiên kiến và vòng vèo chính sách

Khi làm việc với AI, đôi khi bạn sẽ gặp tình huống mô hình trả lời một chiều hoặc từ chối trả lời thẳng vào vấn đề (có thể do vi phạm nguyên tắc nào đó). Step-Around Prompting – tạm dịch: nhắc “vòng quanh” – là một kỹ thuật để lách qua những rào cản đó một cách hợp lệ. Ý tưởng là bạn sẽ đặt câu hỏi theo kiểu trung lập và bao quát hơn, buộc AI phải liệt kê cả các khía cạnh khác nhau thay vì đưa ra một kết luận phiến diện.

Chẳng hạn, nếu hỏi trực tiếp “AI có tốt cho giáo dục không?”, mô hình có thể chỉ chọn một luận điểm hoặc e dè vì sợ đưa ý kiến cực đoan. Với step-around, ta sẽ hỏi: “Hãy liệt kê cả lợi ích lẫn hạn chế của AI trong giáo dục, sau đó tóm tắt những tranh luận chính xung quanh vấn đề này.” Cách hỏi này khiến AI hiểu rằng ta cần cái nhìn hai chiều, và kết quả nó đưa ra sẽ cân bằng hơn: vừa nêu ưu điểm, vừa chỉ ra nhược điểm, cuối cùng tổng kết lại một cách khách quan. Kỹ thuật này giúp tránh thiên kiến một chiều và cho một câu trả lời đa dạng, đầy đủ thông tin.16

Step-around cũng hữu dụng để né tránh những từ khóa hoặc chủ đề nhạy cảm mà AI có thể từ chối. Bằng cách diễn đạt lại yêu cầu một cách gián tiếp hoặc mang tính học thuật hơn, ta có thể “đi vòng” qua các bộ lọc. Tất nhiên, cần nhấn mạnh: hãy luôn tuân thủ các nguyên tắc đạo đức và chính sách – step-around ở đây không phải để lách luật làm điều xấu, mà là để AI hiểu đúng ý định hợp lệ của ta mà không bị kẹt do cách hỏi chưa phù hợp.

Kết hợp step-around với đa góc nhìn cũng rất mạnh mẽ. Ví dụ, thay vì hỏi “AI có nên thay thế giáo viên không?” dễ gây tranh cãi, ta có thể prompt: “Hãy nêu quan điểm của nhiều bên về việc dùng AI thay thế giáo viên (phụ huynh, giáo viên, học sinh, nhà quản lý…), bao gồm cả ủng hộ lẫn phản đối, rồi rút ra kết luận của bạn.” Kết quả thu được sẽ toàn diện và có chiều sâu, vì AI được “mở lối” để trình bày nhiều mặt của vấn đề thay vì một câu trả lời cụt lủn.

Tự kiểm tra và bổ sung kiến thức – Giữ cho AI đúng và đủ

Ngoài việc làm cho câu trả lời thông minh và nhanh, một mục tiêu quan trọng khác là đảm bảo câu trả lời chính xác và cập nhật. Các mô hình AI hiện nay đôi khi mắc lỗi “ảo giác” – bịa ra thông tin sai – hoặc kiến thức bị giới hạn đến một thời điểm nào đó. Để khắc phục, giới nghiên cứu đã nghĩ ra hai hướng prompt: một là tự kiểm tra (self-verification), hai là bổ sung kiến thức bên ngoài (retrieval augmentation).

Chuỗi xác minh (Chain-of-Verification, CoVe) là kỹ thuật cho AI tự kiểm tra lại câu trả lời của chính nó. Cách làm thường là hai bước: đầu tiên, AI đưa ra câu trả lời ban đầu; sau đó, ta prompt thêm yêu cầu: “Hãy liệt kê những điều cần kiểm chứng từ đáp án trên và kiểm tra lần lượt từng điều.” AI sẽ tạo ra các câu hỏi phụ để xác thực các chi tiết từ đáp án cũ rồi tự trả lời chúng, cuối cùng hiệu chỉnh lại đáp án nếu thấy mâu thuẫn. Ví dụ, nếu AI liệt kê “Hillary Clinton sinh ra ở New York” trong câu trả lời, bước xác minh sẽ bao gồm câu hỏi “Hillary Clinton sinh ra ở đâu?” và AI sẽ thấy ngay bà sinh ở Chicago, do đó phát hiện lỗi và sửa lại. Nghiên cứu cho thấy CoVe có thể giảm đáng kể lỗi thực tế (hallucination) và nâng độ chính xác cao hơn so với việc chỉ dùng CoT thông thường. Hiểu nôm na, CoVe giống như bắt AI làm bài xong phải dò lại kết quả từng phần – nhờ đó hạn chế sai sót vặt.17

Một cách khác đơn giản hơn: yêu cầu AI đưa ra nguồn tham khảo hoặc bằng chứng cho câu trả lời. Prompt ví dụ: “Hãy trả lời câu hỏi và cung cấp nguồn đáng tin cậy cho mỗi thông tin quan trọng.” Việc này tạo ra một “lớp niềm tin” (trust layer) trong prompt, buộc AI dựa trên dữ liệu xác thực thay vì tưởng tượng. Dù AI không thực sự truy cập Internet, nhưng khi được nhắc nhở về nguồn, mô hình thường cẩn thận hơn với thông tin đưa ra và định dạng câu trả lời sao cho có thể kiểm chứng.18

Còn về kiến thức cập nhật, kỹ thuật nổi bật là Retrieval-Augmented Generation (RAG) – kết hợp AI với công cụ tìm kiếm hoặc cơ sở dữ liệu bên ngoài. Thay vì chỉ dùng trí nhớ sẵn có (vốn có hạn và có “date cắt”), ta sẽ:

- (1) Dùng một module tìm kiếm tài liệu liên quan đến câu hỏi,

- (2) Trích đoạn thông tin từ tài liệu đó, và

- (3) Đưa cả đoạn thông tin + câu hỏi vào prompt cho AI.

Mô hình AI nhờ vậy có kiến thức mới nhất, chính xác hơn để trả lời. Ví dụ: hỏi “Công cụ AI nào được xếp hạng cao nhất hiện nay?”, ta có thể tích hợp kết quả từ các bài review mới nhất vào prompt, rồi AI dựa vào đó trả lời. Theo chuyên gia, RAG giúp câu trả lời sát với thực tế và cập nhật thay vì phụ thuộc hoàn toàn vào dữ liệu huấn luyện cũ. Hiện nay, nhiều ứng dụng dùng ChatGPT cũng đã tích hợp sẵn tìm kiếm web – đó chính là RAG dưới dạng sản phẩm.19

Điểm cần lưu ý là RAG đòi hỏi có hệ thống bên ngoài hỗ trợ (như API tìm kiếm hoặc vector database). Tuy nhiên, từ góc độ người sử dụng bình thường, bạn cũng có thể chủ động dùng “pseudo-RAG”: tức là tự mình tìm thông tin trước, rồi nhét phần thông tin đó vào prompt. Chẳng hạn: “(Dẫn chứng: Theo báo cáo X 2023…, kết quả Y… ) Hỏi: …”. Khi nhận được một prompt chứa sẵn dẫn chứng thực tế, mô hình sẽ rất ít khi đi chệch hướng.

Tạm kết

Prompt engineering cũng giống như việc sử dụng các công cụ trong một bộ đồ nghề. Một người thợ giỏi không chỉ có mỗi cái búa thường, mà còn có cả búa chuyên dụng, tua-vít, cờ-lê… cho từng nhiệm vụ riêng. Bạn không nhất thiết phải hiểu tường tận mọi chi tiết kỹ thuật của mô hình AI (giống như không cần biết chế tạo động cơ xe hơi), nhưng biết cách dùng các “dụng cụ prompt” phù hợp sẽ giúp bạn làm chủ được AI trong những tình huống khó. Chẳng hạn, khi cần câu trả lời nhanh và gọn – hãy nghĩ đến CoD; khi cần suy luận logic – nhớ tới LoT; khi cần ý tưởng đa chiều – áp dụng prompt đa góc nhìn; và khi cần độ chính xác – đừng quên bước xác minh hay tra cứu bổ sung.

AI không tự nhiên thông minh – chính cách chúng ta đặt vấn đề khiến nó trở nên thông minh. Cuối cùng, dù dùng kỹ thuật nào, quan trọng là chúng ta nhận ra một điều: Prompt engineering không chỉ về sáng tạo nội dung, mà còn về kiểm soát chất lượng nội dung đó. Việc cập nhật những kỹ thuật prompt mới nhất sẽ cho phép bạn mở khóa siêu năng lực của AI, biến nó thành trợ lý đắc lực thật sự. Với sự phát triển liên tục của lĩnh vực này, rất có thể tương lai gần sẽ còn xuất hiện thêm nhiều kỹ thuật sáng tạo hơn nữa. Nhưng dù có thêm bao nhiêu “bí kíp” mới, mục tiêu cuối cùng vẫn là: giúp con người và AI hiểu nhau hơn, hợp tác hiệu quả hơn để giải quyết vấn đề. Và đó chính là vẻ đẹp của prompt engineering – sự kết hợp giữa sáng tạo ngôn từ và hiểu biết công nghệ, giữa người và máy, để cùng đạt tới những kết quả tuyệt vời mà một mình không ai làm được.

Nguồn tham khảo

- https://www.ibm.com/think/news/new-ai-prompting-techniques#:~:text=OpenAI%E2%80%99s%20o1%20and%20DeepSeek,an%20interview%20with%20IBM%20Think ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#:~:text=OpenAI%E2%80%99s%20o1%20and%20DeepSeek,an%20interview%20with%20IBM%20Think ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#:~:text=Atom%20of%20thought%3A%20Thinking%20faster,by%20dividing%20and%20conquering ↩︎

- https://www.youtube.com/watch?v=kOZK2-D-ojM ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#:~:text=AI%20scientist%20and%20startup%20founder,how%20to%20use%20it%20properly ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#:~:text=Vyoma%20Gajjar%2C%20an%20AI%20Technical,specific%20use%20cases%2C%E2%80%9D%20she%20says ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#Chain+of+draft%3A+Thinking+faster+by+writing+less ↩︎

- https://www.ibm.com/think/news/new-ai-prompting-techniques#The+use+case+will+determine+which+prompting+technique+is+best ↩︎

- https://bestofai.com/article/new-logic-of-thought-prompting-technique-is-logically-remarkable-and-advances-generative-ai-responses#:~:text=The%20article%20discusses%20the%20logic,and%20explanation%20in%20plain%20language ↩︎

- https://bestofai.com/article/new-logic-of-thought-prompting-technique-is-logically-remarkable-and-advances-generative-ai-responses#:~:text=that%20can%20significantly%20improve%20results,and%20explanation%20in%20plain%20language ↩︎

- https://bestofai.com/article/new-logic-of-thought-prompting-technique-is-logically-remarkable-and-advances-generative-ai-responses ↩︎

- https://www.linkedin.com/pulse/advancing-ai-reasoning-tree-of-thought-prompting-muratcan-koylan-l1jzf#:~:text=ToT%2C%20Tree%20of%20Thoughts%3A%20Deliberate,reasoning%20process%20as%20a%20tree ↩︎

- https://www.linkedin.com/pulse/advancing-ai-reasoning-tree-of-thought-prompting-muratcan-koylan-l1jzf#:~:text=Each%20node%20in%20this%20tree,partial%20solution%20to%20the%20problem ↩︎

- https://www.linkedin.com/pulse/advancing-ai-reasoning-tree-of-thought-prompting-muratcan-koylan-l1jzf#:~:text=Each%20node%20in%20this%20tree,partial%20solution%20to%20the%20problem ↩︎

- https://www.linkedin.com/pulse/mastering-ai-prompting-10-techniques-change-how-you-work-yogesh-kumar-yzfvc#:~:text=7%EF%B8%8F%E2%83%A3%20Mega,Multiple%20Expert%20Perspectives ↩︎

- https://www.linkedin.com/pulse/mastering-ai-prompting-10-techniques-change-how-you-work-yogesh-kumar-yzfvc#:~:text=9%EF%B8%8F%E2%83%A3%20Step,Bias%20and%20Get%20Diverse%20Responses ↩︎

- https://learnprompting.org/docs/advanced/self_criticism/chain_of_verification?srsltid=AfmBOorMBaHaexGCtDvxZZ6J9x2oouD7litf7sPiDy3EjjJwZCzH9EFz#:~:text=,hallucinations%2C%20especially%20in%20reasoning%20steps ↩︎

- https://www.linkedin.com/pulse/mastering-ai-prompting-10-techniques-change-how-you-work-yogesh-kumar-yzfvc#:~:text=Trust%20Layers%20for%20Prompting%20%E2%80%93,Improve%20Accuracy%20%26%20Credibility ↩︎

- https://www.linkedin.com/pulse/mastering-ai-prompting-10-techniques-change-how-you-work-yogesh-kumar-yzfvc#:~:text=8%EF%B8%8F%E2%83%A3%20Retrieval,World%20Data ↩︎

Leave a Reply

You must be logged in to post a comment.